728x90

반응형

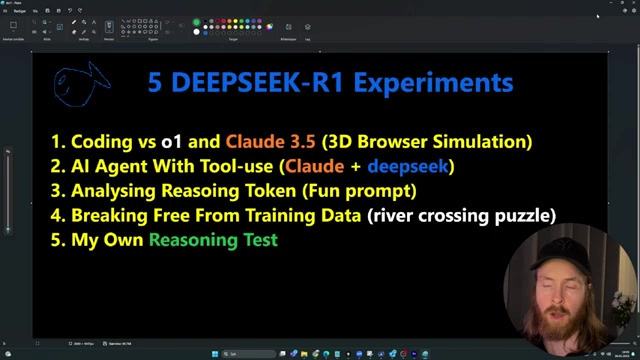

이 영상에서는 DeepSeek-R1 모델과 OpenAI 모델의 성능을 비교하기 위해 다양한 실험을 진행합니다. 실험 중에는 3D 브라우저 시뮬레이션 생성, 도구 사용, 그리고 고전적인 퍼즐 해결과 같은 도전 과제가 포함되어 있습니다. 각 모델의 결과와 그 과정에서의 추론 토큰 분석을 통해 AI의 사고 과정을 엿볼 수 있습니다. 또한, 여러 모델과 API를 조합하여 어떻게 더 좋은 결과를 얻을 수 있는지를 보여줍니다. 이 실험은 AI 기술의 적용 가능성을 탐색하는 데 있어 중요한 통찰을 제공합니다.

반응형

1. 🎮 DeepSeek-R1 실험 및 모델 비교 [00:00:00] (8분)

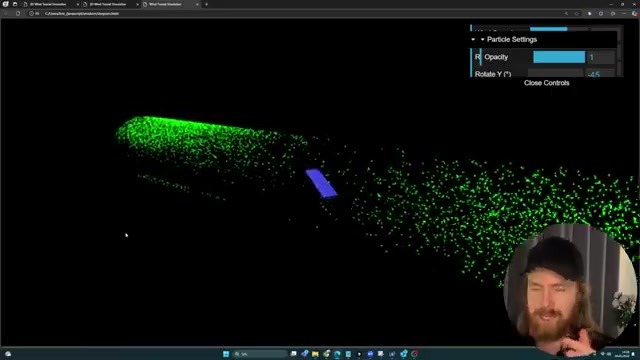

- DeepSeek-R1을 이용한 다섯 가지 실험을 통해 다양한 AI 모델의 성능을 비교하고자 하였다. 첫 번째 실험은 3D 브라우저 기반의 바람 터널 시뮬레이션 코드 작성을 포함하였다.

- 두 번째 실험은 AI 도구의 사용 및 함수 호출을 테스트하며, CLAE 모델과 DeepSeek를 결합하여 추론 토큰을 분석하는 방식으로 진행되었다.

- 네 번째 실험에서는 '강 건너기 퍼즐'의 변형을 통해 모델들이 훈련 데이터에서 벗어나 독자적인 결론을 도출할 수 있는지를 평가하였다.

- 실험 결과, DeepSeek-R1만이 바람 터널 시뮬레이션을 성공적으로 완성하였고, 이는 모델의 차별성을 드러내는 계기가 되었다.

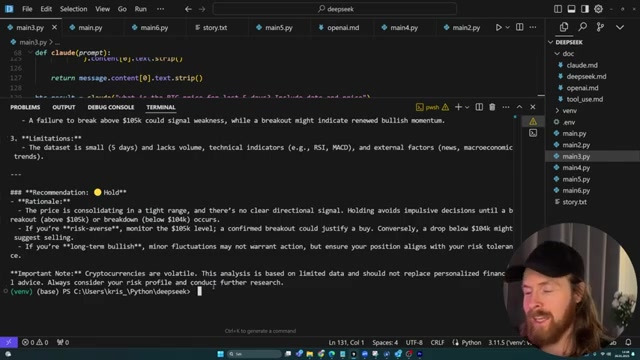

2. 🤖 다양한 도구와 DeepSeek-R1 결합 실험 [00:08:29] (7분)

- Claude의 도구와 DeepSeek-R1의 추론 기능을 결합하여 날씨 정보를 조회하는 실험을 진행하였다. 이를 통해, 날씨 데이터와 질문을 결합하여 논리적 추천도 가능하게 하였다.

- 런던의 날씨를 조회한 결과는 온도 5°C, 보통 비로 나타났고, 이를 토대로 84세 남성의 외출 여부를 추천하기 위해 여건을 분석하였다.

- 비가 오는 날의 특성을 고려하여 외출을 지연하고, 위험 요소를 피하는 것이 좋다는 결론을 도출하였다.

- 또한, 비트코인 가격 조회 기능을 추가하여, 최근 5일간 가격 변동을 분석하고 판매 또는 보유에 대한 조언을 제공하는 방식으로 실험을 확장하였다.

- 마지막으로, 가격 추세가 높은 지점에서 떨어지지 않도록 보유하는 전략을 추천하였으며 암호화폐의 변동성을 주의사항으로 강조하였다.

3. 🤖 DeepSeek-R1의 추론 프로세스 테스트 [00:16:24] (9분)

- 사용자는 1부터 100 사이의 숫자를 생각하도록 요청받고, 모델은 추론 토큰을 활용하여 답을 탐색한다. 사용자는 "50"이나 "5 또는 10의 배수"와 같은 흔한 숫자를 피하고, 상대적으로 덜 자주 선택되는 소수를 선택하려고 한다.

- 모델은 여러 후보 숫자에 대해 생각의 과정을 거치며, 최종적으로 소수인 73을 선택한다. 73은 넘어가도 안전하고, 직접 나타나지 않을 가능성이 높다.

- 이어지는 실험에서는 유명한 퍼즐을 제시하고, 모델이 이전 훈련 데이터에서 벗어나 그 문제를 해결할 수 있는지를 테스트한다. 문제의 조건을 완전히 새로운 형태로 바꿔 제공한다.

- 모델들은 퍼즐의 진행에 대한 자신들의 추론 과정을 거치며, 결국 모든 모델이 특정 개념과 방법으로 퍼즐에 접근한다. 하지만 사용자의 잘못된 정보를 토대로 헷갈리기도 한다.

- DeepSeek-R1과 Claude 모델은 퍼즐을 해결할 수 있었지만, OpenAI 모델은 반응이 느리며 해결하지 못하는 오류를 보인다. Claude와 DeepSeek-R1은 최종적으로 "남자가 염소를 보트에 태우고 건너간다"라고 답변한다.

3.1. 숫자 추측 게임에서의 사고 과정 [00:16:24] (3분)

- 사용자가 추측할 숫자를 1에서 100 사이로 설정하는 프롬프트를 테스트하였다.

- R1은 추리 토큰을 사용하여 숫자를 선택해야 하며, 사용자에게 너무 쉽게 맞추지 않도록 하려 했다.

- 숫자 선택 과정에서 흔히 선택되는 숫자(예: 50, 5의 배수) 외에도, 소수 숫자를 선택하는 것이 더 좋다고 언급했다.

- 다양한 소수 숫자(예: 37, 73)에 대해 생각하며 고민하는 과정을 보여주었고, 결국 73을 선택했다.

- 이러한 과정은 재미있고, AI가 인간처럼 사고하도록 시도하는 흥미로운 예시로 언급되었다.

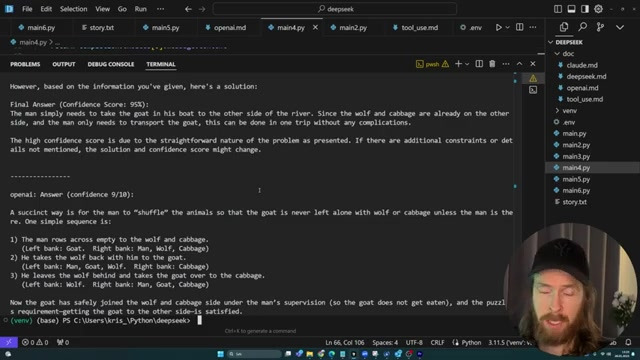

3.2. LLM 실험: 퍼즐 해결 능력 테스트 [00:19:56] (1분)

- 다음 실험은 훈련 데이터에 근접한 질문을 던져, LLM이 가장 명백한 답변을 피하고 해결책을 찾을 수 있는지를 테스트하는 것이다.

- 실험에서 사용된 퍼즐은 강가에 있는 남자, 염소, 늑대, 그리고 양배추를 포함한 유명한 문제이다.

- 남자가 배를 타고 강의 반대편으로 가려면, 염소와 늑대 사이를 오가며 무엇인가를 되가져와야 한다는 조건이 있다.

- 실험의 독창적인 부분은 모델이 훈련 데이터에서 벗어나 해답을 찾도록 도전하는 변형된 질문을 사용하는 것이다.

- 세 가지 모델(DeepSeek-R1, CLAE, Open AR)을 실행하고 결과를 비교할 예정이다.

3.3. 퍼즐 실험 결과 요약 [00:21:47] (2분)

- 실험 결과, 퍼즐 구조는 기존의 클래식 문제와 다르게 나타나며, 이는 훈련 데이터와의 다툼으로 이어진다.

- 사용자가 제공한 설명에 따르면, 답은 남자가 염소를 배에 태워서 건너가는 것이며, 이는 직관적이어서 신뢰도 점수는 95다.

- 남자가 염소와 함께 있어도 별도의 추가 단계가 필요하지 않은 이유는 그의 존재가 갈등을 방지하기 때문이다.

- 퍼즐 설명에 오해가 발생할 수 있으며, 이는 Claude에게 사과하는 문맥에서 나타난다.

- 최종 결론은 남자가 염소를 다른 쪽으로 가져가는 것이며, 이미 늑대와 양배추가 어느 쪽에 있는지가 중요한 요소로 작용한다.

3.4. 모델 성능 비교 결과 [00:24:21] (1분)

- Claude는 정답을 맞췄지만, OpenAI 01 모델은 문제를 해결하지 못했고, 이는 놀라운 결과다.

- 실험을 재차 진행했으나, 01 모델은 정답을 도출하지 못하고 계속해서 고민하는 상태에 머물렀다.

- DeepSeek와 Claude는 문제를 올바르게 해결했으며, 01 모델은 이 과정을 재현하지 못했다.

- 01은 이전에는 정답을 맞춘 경험이 있었기 때문에 이번 결과는 이상적이다.

- 챗봇 모델들이 문제를 푸는 과정에서 사고 토큰을 소모했다는 점은 눈에 띄는 특징이다.

4. 🎨 DeepSeek-R1 실험의 결과 [00:26:03] (5분)

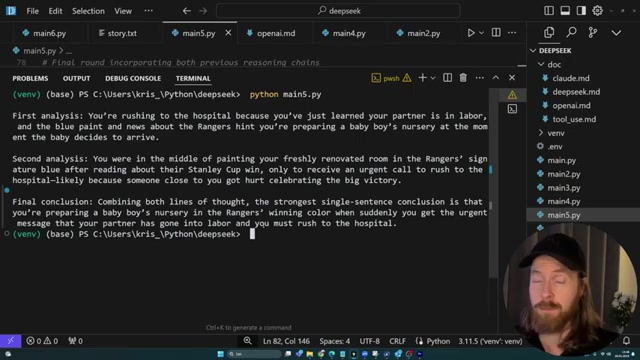

- DeepSeek-R1을 이용하여 주어진 단서들을 조합해 상황을 추론하는 실험을 진행했다.

- "파란 페인트가 있는 양동이"와 "개조된 방" 등 단서들이 어떤 상황을 암시하는지 확인했다.

- 최종 결론은 파트너가 출산 중이라는 내용으로, 이는 새로 개조된 방과 급한 병원 호출에서 유추된 것이다.

- 그러나, 실험에서 제시된 내용 중 하나는 "뉴욕 레인저스의 스탠리컵 우승"과 관련된 의료 응급 상황으로의 전개가 있었다.

- 추가적인 실험에서도 동등한 결론에 도달했으며, 이는 DeepSeek-R1의 추론 능력에 대한 긍정적인 평가를 이끌어냈다.

728x90

5. 🔍 향후 실험과 모델 발전 [00:31:17] (41초)

- 향후 모델의 성능이 좋아질 것이라는 소문이 있으며, 그에 따라 흥미로운 발전이 기대된다.

- 이번 실험들이 유익했기를 바라며, 이후에도 더 많은 실험이 진행될 것이라고 언급되었다.

- 로컬 모델을 곧 시도할 계획이 있음도 밝혀졌다.

- 현재 API만 사용하고 있지만, 추후에는 다른 시스템에서 테스트할 가능성도 있다.

- 시청에 대한 감사를 표하며, 다음 대화에서 다시 만날 것임을 언급했다.

LIST

'IT > AI news&info' 카테고리의 다른 글

| 인공지능도 이기는 상위 0.1% 멘탈 갖추는 법ㅣ지식인초대석 EP.23 (이세돌 전 바둑기사 1부) (1) | 2025.02.09 |

|---|---|

| "더 싸고 더 똑똑하다" 중국산 AI...돈 쏟아붓는 미국의 위기감 (2) | 2025.02.08 |

| '몇 년 남지 않았다' 대체될 것인가 살아남을 것인가 'AI와 미래' (0) | 2025.02.07 |

| 딥시크가 뭐길래, AI 주식들이 폭락했나 (0) | 2025.02.04 |

| 2025-02-02 조코딩 AI 뉴스 [o3-mini 출시, 딥시크 R1 총정리 및 영향, Grok 3 일부 출시, 알리바바 Qwen 2.5-Max, AI 저작권 등] (1) | 2025.02.03 |